ИИ научился распознавать мысли человека без мозговых имплантатов

Австралийские исследователи из проекта «DeWave» Технологического университета Сиднея столкнулись с неопределенной сложностью при разработке своего интерфейса для чтения мыслей. Преимущество их разработки в том, что она не требует имплантации электродов в живой организм. Достаточно надеть специальную шапочку для снятия электроэнцефалограммы и преобразования мозговых импульсов в некий код.

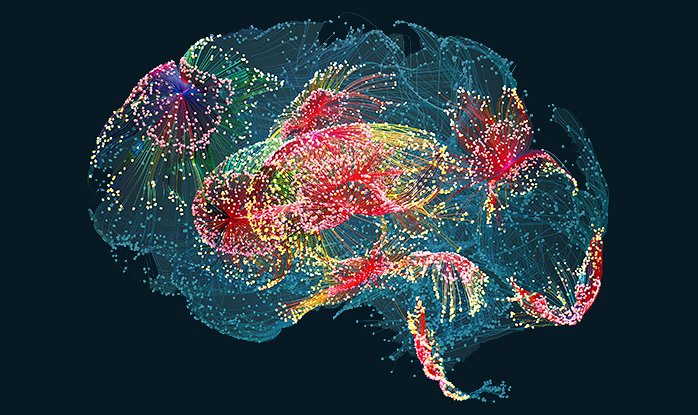

Процесс считывания активности мозга уже не представляет сложностей, но вот интерпретация сигналов – задача практически не решаемая. Во-первых, у всех людей разная физиология, поэтому мелкие нюансы полученных сигналов искажают общую картину. Во-вторых, человек не робот и его мозг не может сосредоточиться только на одной задаче, огромная доля полученных сигналов вообще не имеют к ней никакого отношения. В-третьих, даже такая простая задача, как чтение текста, выполняется людьми по-разному, из-за чего нельзя составить единый алгоритм обработки данных.

Выход нашелся быстро – ученые использовали технологии нейросетей с их возможностью самообучения для получения некоего «распознавателя мозговых сигналов». Эта система в дополнение к данным ЭЭГ использовала информацию с камер для отслеживания положения глаз при чтении текста. ИИ учился сопоставлять импульсы мозга и поведение глаз, чтобы реагировать только на чтение текста и превращать сигналы в код, а тот – в конкретные слова.

И вот тут случилась проблема, связанная с тем, что нейросеть по умолчанию стремится к оптимизации выдачи. Вместо распознавания точных слов она искала смысловые образы, старалась передать суть послания, но не его детали. Из-за этого «мужчина» превращался в «человека», тот в «автора», «персонажа», «личность» и т.д. Для большинства задач это не имеет значения, но по своей сути такая технология работает неправильно. Ученые пришли к выводу, что языковые модели ИИ еще учить и учить, прежде чем они смогут использоваться в работе с живым мозгом человека. Или же лучше не рисковать вовсе.

Свежие комментарии